扫描分享

本文共字,预计阅读时间。

1. 什么是SVM

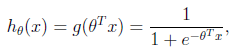

首先我们重新审视一下逻辑回归。对于逻辑回归,是从样本特征学习出一个0/1分类模型,模型是将特征的线性组合作为自变量。又由于该自变量的取值范围是从负无穷到正无穷,所以使用sigmoid函数将该自变量映射到(0,1)的范围上,映射后的值可以看作是样本属于y = 1的概率。

逻辑回归常常用于解决线性可分的分类问题,当面对线性不可分的问题时,这就用到了非线性分类器——支持向量机。

支持向量机(Support Vector Machine,SVM)是一种二分类算法模型,其基本模型是定义在特征空间上的间隔最大的线性分类器。支持向量机的学习策略就是分类间隔最大化,该策略可形式化为一个求解凸二次规划的问题,也等价于正则化的合页损失函数的最小化问题。

相比于逻辑回归会兼顾所有的样本点尽可能远离分类超平面,SVM只关心局部的边界线附近的样本点,即支持向量,而不是在所有样本点上达到最优。所以SVM不完全依赖于数据的分布,也不会受异常点的影响。

2. 都有什么类型的SVM

根据训练样本是否线性可分,我们可以将支持向量机分为以下几类:

(1)线性可分支持向量机

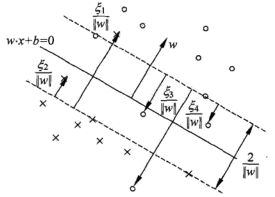

当训练样本是线性可分时,存在无穷多个分类超平面可实现两类数据的分类。通过硬间隔最大化学习一个线性的分类器,即线性可分支持向量机。

![]()

(2)线性支持向量机

当训练样本近似线性可分时,线性可分的支持向量机对线性不可分训练数据是不适用的,这就需要修改硬间隔最大化成为软间隔最大化,通过软间隔最大化学习一个线性的分类器,即线性支持向量机。在除去造成线性不可分的训练数据特异点后,剩下的样本点是线性可分的,通过对每个样本点引入一个松弛变量,使函数间隔加上松弛变量满足约束条件。目标函数则变成,这里的C称为惩罚系数,C值越大表示对误分类的惩罚越大。

(3)非线性支持向量机

当训练样本线性完全不可分时,通过使用核技巧,学习非线性支持向量机。这种情形下,等价于隐式地在高维的特征空间中学习线性支持向量机。

3. 核技巧与核函数

SVM中的核技巧指的是,对于非线性分类问题,首先使用一个变换实现将输入空间中的数据映射到一个新的特征空间(希尔伯特空间),在这个新空间中原问题转换为线性可分问题,应用线性分类学习方法从数据中学习得到分类模型,使得输入空间中的超曲面模型对应于特征空间中的超平面模型。

在线性支持向量机的对偶问题中,其目标函数和决策函数中,只涉及到样本数据之间的内积计算,在对偶问题中目标函数的内积可使用核函数来替代。

类似于神经网络中的激活函数,SVM中不同的核函数有不同的适用场景。常用的核函数包括多项式核函数、高斯核函数、径向基核函数、字符串核函数等。

4. SVM在风控建模中的应用

坏样本对于建立风控模型至关重要,如果坏样本数量不够,建模时则无法设定理想的参数,实现模型调优。由于银行和机构严格的信贷审批机制,积累的坏样本数量较少。在建立风控模型时,掌握规模太小的坏样本,无法构建优化已有的模型和提高风控模型的泛化能力。

由于支持向量机的训练过程只需要支持向量,依赖的训练样本训练样本数较小,使其对小样本建模具有优势。对于使用支持向量机建模,其在小样本、非线性及高维模式识别中具有独特的优势,同时SVM也是努力最小化结构风险的算法。另外,在建模训练的时间开销上,支持向量机只依赖小样本,其训练时间开销也具备很大优势。

文/天机模型算法团队 张俊皓

非常感谢您的报名,请您扫描下方二维码进入沙龙分享群。

非常感谢您的报名,请您点击下方链接保存课件。

点击下载金融科技大讲堂课件本文系未央网专栏作者发表,属作者个人观点,不代表网站观点,未经许可严禁转载,违者必究!首图来自图虫创意。

本文为作者授权未央网发表,属作者个人观点,不代表网站观点,未经许可严禁转载,违者必究!首图来自图虫创意。

本文版权归原作者所有,如有侵权,请联系删除。首图来自图虫创意。

京公网安备 11010802035947号

京公网安备 11010802035947号